Pictet | Frankfurt, 14.09.2023.

Pictet | Frankfurt, 14.09.2023.

Large Language Models wie ChatGPT sind eine neue Technologie, die unsere Art zu kommunizieren verändern wird – überwiegend zum Besseren.

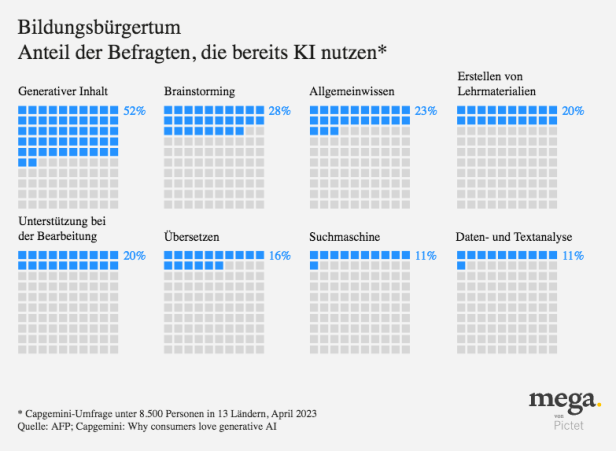

Vor nicht allzu langer Zeit produzierten Sprachmodelle der künstlichen Intelligenz kaum mehr als Babysprache. Doch auf einmal sind sie schlau genug, um Prüfungen auf Hochschulniveau zu bestehen. Das ist eine echte Revolution.

Viele Beschäftigte sehen darin eine Bedrohung für ihren Job, aber das muss nicht so sein, sagt Greene. Programme wie ChatGPT werden nicht nur immer besser bei der Verrichtung alltäglicher Aufgaben, sondern sie verschaffen den Mitarbeitern auch Zeit, sich anspruchsvolleren und interessanteren Aufgaben zu widmen, wie der Kontrolle der Ergebnisse der LLMs.

ChatGPT könnte sogar die Rettung für weniger effektive und weniger produktive Arbeitskräfte sein. In der Financial Times zitiert der Kolumnist Tim Harford Studien, die zeigen, dass sich Produktivitätsverbesserungen auf die am wenigsten effektiven Arbeitnehmer konzentrieren – Homer Simpsons, wie er sie nennt –, während die Technologie bei den kompetentesten von ihnen nur wenig zur Leistung beiträgt.1

Bei all ihren revolutionären Fähigkeiten haben LLMs auch ihre Probleme. Wie die Tatsache, dass sie sich Dinge ausdenken. Ihre Entwickler sind sich nicht ganz sicher, warum das so ist, sagt Greene, aber LLMs enthalten immer wieder Informationen, die nicht wahr sind. Und diese wirken meist sehr überzeugend, was es umso gefährlicher macht.

Ein New Yorker Rechtsanwalt musste vor kurzem am eigenen Leib erfahren, wie gefährlich es ist, sich auf ChatGPT zu verlassen. Er nutzte das LLM, um ein juristisches Schriftstück in einer Rechtssache, die einen Personenschaden betraf, aufzusetzen, nur um dann von dem Richter gerügt zu werden, weil er sechs nicht existierende Gerichtsurteile zitiert hatte.2

Lehrer machen sich Sorgen darüber, wie sie mit Schülern umgehen sollen, die sich vor den Hausaufgaben drücken wollen und von ChatGPT Aufsätze erstellen lassen. Eine Möglichkeit besteht darin, sich auf die Schwächen von ChatGPT zu konzentrieren. Einige Lehrer geben ihren Schülern die Aufgabe, tatsächlich mit ChatGPT einen Aufsatz zu erstellen und das Ergebnis dann zu analysieren, um falsche Informationen herauszufiltern.

ChatGPT „saugt eine riesige Menge an Material aus dem Internet“ und es ist gut darin, das wiederzugeben, womit es gefüttert wird. Das geht aber weniger gut mit Wissen, das für uns Menschen selbstverständlich oder selbsterklärend ist, oder mit Fragen, die logisches Denken erfordern. So geht ChatGPT beispielsweise nicht davon aus, dass jemand, der vor einer Stunde am Leben war und der die nächsten zwei Stunden am Leben ist, auch in der Zeit dazwischen am Leben ist, so Greene. Es gibt nicht viel Material im Netz, das diesen Sachverhalt erklärt, denn für den Menschen ist das selbstverständlich.

Ein weiteres Problem ist, dass ChatGPT die Voreingenommenheiten des Materials übernimmt, für das es trainiert wurde, sagt Greene. Je breiter das Material, desto schwieriger ist es, die Verzerrung auszugleichen. Es ist möglich, diese Verzerrung zu eliminieren oder abzumildern, indem die Trainingsinhalte sorgfältig ausgewählt werden, aber das schränkt dann den Nutzen des Modells ein. Ein weiterer Ansatz besteht darin, explizite Regeln festzulegen, die die Trainingsdaten überlagern und zum Beispiel vorgeben „Beantworte keine Fragen, die dich als rassistisch erscheinen lassen“, aber solche Regeln werden vermutlich nie perfekt sein.

Gleichzeitig kann es sein, dass ChatGPT aufgrund der Breite des Materials illegale oder gefährliche Informationen bereitstellt, zum Beispiel wie Napalm oder Drogen wie Crystal Meth hergestellt werden können. Die Entwickler von ChatGPT haben Sicherheitsmechanismen eingebaut, aber die Benutzer entdecken jeden Tag neue Workarounds, so Greene. Aufgrund dieser Hintertüren stehen die Schöpfer von LLMs immer mit einem Fuss im Gefängnis.

Greene gibt ChatGPT aus drei Dimensionen eine Note. „Für den Faktenabruf bekommt es eine 1+, für das Nachahmen der Leistung des Menschen ein Ausreichend. Wirft man beides in die Waagschale, besteht es gerade so. Es hat nämlich grosse Mängel“, sagt er.

Trotz aller Unzulänglichkeiten hat ChatGPT schnelle Fortschritte gemacht und die Entwicklung geht weiter. Doch angesichts der Strukturen dieser Modelle – nicht zuletzt ihrer Abhängigkeit von Trainingsdaten – wird es schwer werden, echte originale Inhalte zu erzeugen.

„Das Erkunden von Dingen, von denen niemand oder kaum jemand etwas weiss, bleibt weiterhin dem Menschen vorbehalten“, sagt Greene. Recherche-Journalismus ist also unersetzlich, anders als der „Churnalismus“, also der „Schreibtischjournalismus“, der einfach bereits vorliegende Informationen weitestgehend unverändert und ungeprüft nochmals „aufschäumt“. Originalität und Neuartigkeit werden ein wichtiges Unterscheidungsmerkmal sein. Eine Blackbox kann nicht tiefgreifend neu denken. Es wird immer Raum für einprägsame, einfache, klare Prosa geben, die durch passende Bilder und Metaphern mit Leben erfüllt wird.

ChatGPT kann als Ausgangspunkt für schriftliche Arbeiten dienen, aber menschlicher Input ist notwendig, um dem Output einen Sinn zu geben. Übersetzer werden zu Post-Editoren, die mithilfe von LLMs einen ersten Entwurf erstellen, den sie dann überprüfen, um sicherzustellen, dass keine Nuancen verloren gehen und subtile sprachliche Fallstricke vermieden werden.

Die Menschen lechzen nach Authentizität. ChatGPT verändert vielleicht die Form der schriftlichen Erzeugnisse, aber es macht Autoren nicht überflüssig. „So wie die Fotografie nicht das Ende der Malerei bedeutete, sondern nur veränderte, was und wie gemalt wurde“, so Greene.

[1] https://www.ft.com/content/74c63f77-f543-4be0-9cd9-2f5f40ba6f17[2] https://www.reuters.com/legal/transactional/lawyer-used-chatgpt-cite-bogus-cases-what-are-ethics-2023-05-30/

Kontakt:

Pictet Asset Management

Neue Mainzer Strasse 1

60311 Frankfurt

Telefon : +49 69 79 500 90